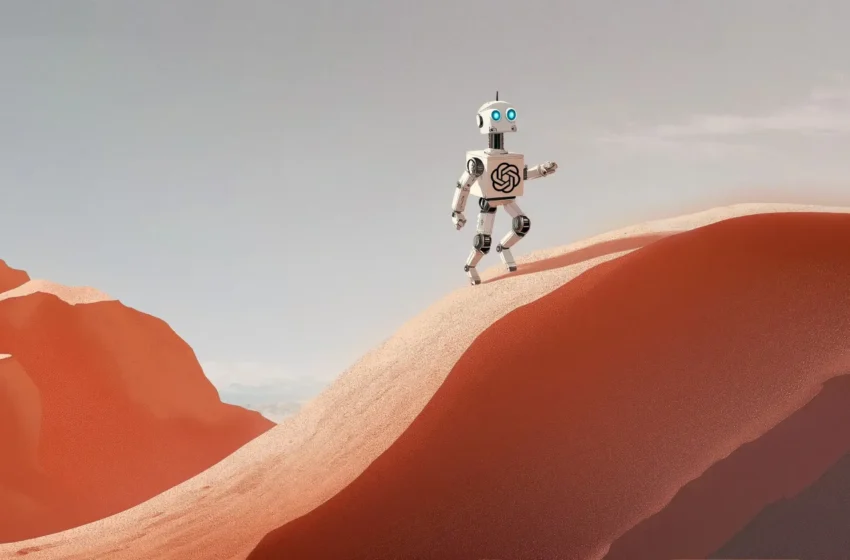

مدلهای زبانی بزرگ (LLM) هنوز هم به طور کامل قابل اعتماد نیستند

تحقیقات اخیر نشان داده است که با وجود پیشرفتهای چشمگیر در مدلهای زبانی بزرگ (LLM) و هوش مصنوعی مولد (GenAI)، این سیستمها هنوز هم محدودیتهای جدی دارند و نمیتوان به طور کامل به آنها اعتماد کرد. به گزارش سرویس اخبار فناوری رسانه تکنولوژی تکنا، این یافتهها میتواند پیامدهای مهمی برای مدلهای هوش مصنوعی مولد در […] منبع خبر مدلهای زبانی بزرگ (LLM) هنوز هم به طور کامل قابل اعتماد نیستند پایگاه خبری تکنا به آدرس تکنا میباشد.

تحقیقات اخیر نشان داده است که با وجود پیشرفتهای چشمگیر در مدلهای زبانی بزرگ (LLM) و هوش مصنوعی مولد (GenAI)، این سیستمها هنوز هم محدودیتهای جدی دارند و نمیتوان به طور کامل به آنها اعتماد کرد.

به گزارش سرویس اخبار فناوری رسانه تکنولوژی تکنا، این یافتهها میتواند پیامدهای مهمی برای مدلهای هوش مصنوعی مولد در دنیای واقعی داشته باشد. به ویژه اینکه یک LLM که در یک زمینه خاص عملکرد خوبی دارد، ممکن است در صورت تغییر جزئی در وظیفه یا محیط، عملکرد ضعیفی از خود نشان دهد. این مطالعه توسط محققان دانشگاه هاروارد، موسسه فناوری ماساچوست (MIT)، دانشگاه شیکاگو بوت و دانشگاه کرنل انجام شده است. LLMها توانایی خود را در زمینههای مختلفی مانند نوشتن، تولید برنامههای کامپیوتری و فعالیتهای دیگر نشان دادهاند.

این موضوع میتواند این تصور را ایجاد کند که این مدلها در حال یادگیری حقایق کلی در مورد جهان هستند، اما مطالعه جدید نشان میدهد که اینطور نیست. در این مطالعه جدید، محققان دریافتند که یک نوع محبوب از مدلهای GenAI میتواند با دقت تقریباً کامل، مسیرهای رانندگی مرحله به مرحله را در شهر نیویورک ارائه دهد، بدون اینکه نقشه دقیقی از شهر را در ذهن خود تشکیل داده باشد. با این حال، هنگامی که محققان برخی از خیابانها را بستند و مسیرهای جایگزین را اضافه کردند، عملکرد ناوبری LLM به طور قابل توجهی کاهش یافت.

پس از بررسی، محققان دریافتند که نقشه نیویورک که توسط LLM تولید شده بود، “شامل بسیاری از خیابانهای غیر واقعی بود که بین شبکه خیابانها منحنی شده و تقاطعهای دور را به هم متصل میکردند. آشیش رامباچان، استاد اقتصاد و محقق اصلی در آزمایشگاه اطلاعات و سیستمهای تصمیمگیری MIT (LIDS)، گفت: «این سوال که آیا LLMها مدلهای جهانی منسجمی را یاد میگیرند، بسیار مهم است اگر میخواهیم از این تکنیکها برای کشفهای جدید استفاده کنیم.»

این تحقیق در کنفرانس پردازش اطلاعات عصبی ارائه خواهد شد. برای این مطالعه، محققان بر روی نوعی مدل GenAI متمرکز شدند که به عنوان ترانسفورمر شناخته میشود و ستون فقرات LLMهایی مانند GPT-4 را تشکیل میدهد.

طبق یک بیانیه مطبوعاتی MIT، ترانسفورمرها با مقدار زیادی داده مبتنی بر زبان آموزش داده میشوند تا توکن بعدی در یک دنباله، مانند کلمه بعدی در یک جمله، را پیشبینی کنند. با این حال، به گفته محققان، هنگام تعیین اینکه آیا LLM یک مدل دقیق از جهان را تشکیل داده است یا خیر، اندازهگیری دقت پیشبینیهای آن کافی نیست.

در مثال دیگری، آنها دریافتند که یک ترانسفورمر میتواند تقریباً در هر زمان، حرکات معتبر را در بازی Connect 4 پیشبینی کند، بدون اینکه هیچ یک از قوانین را درک کند. بنابراین، تیم دو معیار جدید را توسعه داد که میتواند مدل جهانی یک ترانسفورمر را آزمایش کند. محققان ارزیابیهای خود را بر روی کلاسی از مسائل متمرکز کردند که به عنوان اتوماتای متناهی قطعی (DFA) شناخته میشوند. یک DFA مسئلهای با دنبالهای از حالات، مانند تقاطعهایی است که باید برای رسیدن به یک مقصد طی شود، و یک روش مشخص برای توصیف قوانینی که باید در طول مسیر دنبال شوند.

در یک چرخش کاملاً غیرمنتظره، محققان دریافتند که ترانسفورمرهایی که به صورت تصادفی انتخاب میکردند، مدلهای جهانی دقیقتری را تشکیل میدادند. اگرچه ترانسفورمرها در تقریباً هر مورد، جهتهای دقیق و حرکات معتبر را تولید میکردند، اما دو معیار نشان داد که فقط یکی از آنها یک مدل جهانی منسجم برای حرکات ایجاد کرده بود و هیچکدام در تشکیل مدلهای جهانی منسجم در مثال ناوبری عملکرد خوبی نداشتند.

برای مشاهده تازه ترین خبرها به صفحه اخبار فناوری رسانه تکنا مراجعه کنید.

منبع خبر مدلهای زبانی بزرگ (LLM) هنوز هم به طور کامل قابل اعتماد نیستند پایگاه خبری تکنا به آدرس تکنا میباشد.

واکنش شما چیست؟