کشف آسیبپذیری گسترده در سیستمهای یادگیری ماشینی

تحلیلهای اخیر نشان میدهد که سیستمهای یادگیری ماشینی متنباز در معرض تهدیدات امنیتی بیشتری نسبت به سیستمهای بالغتر مانند DevOps یا سرورهای وب هستند. با افزایش استفاده از یادگیری ماشینی در صنایع مختلف، نیاز به ایمنسازی سیستمهای یادگیری ماشینی بسیار حیاتی شده است زیرا آسیبپذیریها میتوانند منجر به دسترسی غیرمجاز، نقض دادهها و اختلال در […] منبع خبر کشف آسیبپذیری گسترده در سیستمهای یادگیری ماشینی پایگاه خبری تکنا به آدرس تکنا میباشد.

تحلیلهای اخیر نشان میدهد که سیستمهای یادگیری ماشینی متنباز در معرض تهدیدات امنیتی بیشتری نسبت به سیستمهای بالغتر مانند DevOps یا سرورهای وب هستند. با افزایش استفاده از یادگیری ماشینی در صنایع مختلف، نیاز به ایمنسازی سیستمهای یادگیری ماشینی بسیار حیاتی شده است زیرا آسیبپذیریها میتوانند منجر به دسترسی غیرمجاز، نقض دادهها و اختلال در عملیات شوند.

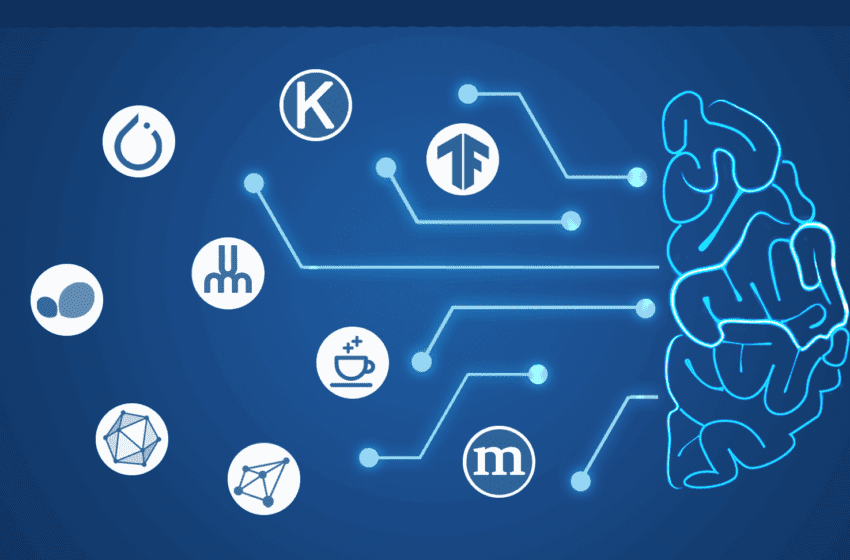

به گزارش سرویس امنیت رسانه اخبار فناوری تکنا به نقل از JFrog ، پروژههای یادگیری ماشینی مانند MLflow شاهد افزایش آسیبپذیریهای بحرانی بودهاند. در چند ماه گذشته، JFrog 22 آسیبپذیری در 15 پروژه متنباز یادگیری ماشینی کشف کرده است. از جمله این آسیبپذیریها، دو دسته برجسته میشوند: تهدیدهایی که مؤلفههای سمت سرور را هدف قرار میدهند و خطرات افزایش امتیازات در چارچوبهای یادگیری ماشینی.

آسیبپذیریهایی که توسط JFrog شناسایی شدهاند، مؤلفههای کلیدی که اغلب در گردش کارهای یادگیری ماشینی استفاده میشوند را تحت تأثیر قرار میدهند و این امر میتواند به مهاجمان اجازه دهد تا از ابزارهایی که اغلب توسط متخصصان یادگیری ماشینی به دلیل انعطافپذیری آنها مورد اعتماد هستند، سوء استفاده کرده و به فایلهای حساس دسترسی غیرمجاز پیدا کنند یا امتیازات خود را در محیطهای یادگیری ماشینی افزایش دهند.

یکی از آسیبپذیریهای برجسته مربوط به Weave، یک ابزار محبوب از Weights & Biases (W&B) است که به ردیابی و تجسم معیارهای مدل یادگیری ماشینی کمک میکند. آسیبپذیری پیمایش دایرکتوری WANDB Weave (CVE-2024-7340) به کاربران با امتیازات پایین اجازه میدهد تا به فایلهای دلخواه در سراسر سیستم فایل دسترسی پیدا کنند.

این نقص به دلیل اعتبارسنجی نادرست ورودی هنگام مدیریت مسیرهای فایل رخ میدهد و به مهاجمان اجازه میدهد تا به فایلهای حساس مانند کلیدهای API ادمین یا سایر اطلاعات محرمانه دسترسی پیدا کنند. چنین نقضی میتواند منجر به افزایش امتیازات و اعطای دسترسی غیرمجاز به منابع به مهاجمان شود و امنیت کل خط لوله یادگیری ماشینی را به خطر بیاندازد.

ZenML، یک ابزار مدیریت خط لوله MLOps، نیز تحت تأثیر یک آسیبپذیری بحرانی است که سیستمهای کنترل دسترسی آن را به خطر میاندازد. این نقص به مهاجمان با حداقل امتیازات اجازه میدهد تا مجوزهای خود را در ZenML Cloud افزایش دهند که یک استقرار مدیریت شده از ZenML است و در نتیجه به اطلاعات محدود شده از جمله اسرار محرمانه یا فایلهای مدل دسترسی پیدا کنند.

مسئله کنترل دسترسی در ZenML سیستم را در معرض خطرات قابل توجهی قرار میدهد، زیرا افزایش امتیازات میتواند به مهاجم اجازه دهد تا خط لولههای یادگیری ماشینی را دستکاری کند، دادههای مدل را جعل کند یا به دادههای عملیاتی حساس دسترسی پیدا کند و در نتیجه بر محیطهای تولیدی متکی بر این خط لولهها تأثیر بگذارد.

آسیبپذیری جدی دیگری به نام تزریق فرمان Deep Lake (CVE-2024-6507) در پایگاه داده Deep Lake یافت شده است – یک راه حل ذخیرهسازی داده بهینه شده برای برنامههای هوش مصنوعی. این آسیبپذیری به مهاجمان اجازه میدهد تا با سوء استفاده از نحوه مدیریت واردات مجموعه دادههای خارجی توسط Deep Lake، دستورات دلخواه را اجرا کنند.

به دلیل پاکسازی نادرست فرمان، یک مهاجم میتواند به طور بالقوه اجرای کد از راه دور را انجام دهد و امنیت هر دو پایگاه داده و هر برنامه متصل شده را به خطر بیاندازد.

یک آسیبپذیری قابل توجه نیز در Vanna AI، ابزاری برای تولید و تجسم پرسوجوی SQL با زبان طبیعی، یافت شده است. تزریق اعلان Vanna.AI (CVE-2024-5565) به مهاجمان اجازه میدهد تا کد مخرب را در اعلانهای SQL تزریق کنند که این ابزار در ادامه آن را پردازش میکند. این آسیبپذیری که میتواند منجر به اجرای کد از راه دور شود، به بازیگران مخرب اجازه میدهد تا ویژگی تجسم SQL به نمودار Vanna AI را هدف قرار دهند تا تجسمها را دستکاری کنند، تزریق SQL انجام دهند یا دادهها را خارج کنند.

Mage.AI، یک ابزار MLOps برای مدیریت خط لولههای داده، دارای چندین آسیبپذیری از جمله دسترسی غیرمجاز به پوسته، نشت فایلهای دلخواه و بررسیهای ضعیف مسیر است.

این مسائل به مهاجمان اجازه میدهد تا کنترل خط لولههای داده را به دست بگیرند، پیکربندیهای حساس را افشا کنند یا حتی دستورات مخرب را اجرا کنند. ترکیب این آسیبپذیریها خطر افزایش امتیازات و نقض یکپارچگی دادهها را افزایش میدهد و امنیت و پایداری خط لولههای یادگیری ماشینی را به خطر میاندازد.

با کسب دسترسی ادمین به پایگاه دادهها یا رجیستریهای یادگیری ماشینی، مهاجمان میتوانند کد مخرب را در مدلها جاسازی کنند و منجر به ایجاد درهای پشتی شوند که هنگام بارگذاری مدل فعال میشوند. این امر میتواند فرآیندهای پاییندستی را به خطر بیاندازد زیرا مدلها توسط تیمهای مختلف و خط لولههای CI/CD استفاده میشوند. مهاجمان همچنین میتوانند دادههای حساس را خارج کنند یا حملات مسمومسازی مدل را برای کاهش عملکرد مدل یا دستکاری خروجیها انجام دهند.

یافتههای JFrog یک شکاف عملیاتی در امنیت MLOps را برجسته میکند. بسیاری از سازمانها ادغام قوی از شیوههای امنیتی AI/ML با استراتژیهای گستردهتر امنیت سایبری ندارند و این امر باعث ایجاد نقاط کور بالقوه میشود. با توجه به پیشرفتهای قابل توجه صنعت در زمینه ML و AI، محافظت از چارچوبها، مجموعه دادهها و مدلهایی که این نوآوریها را تقویت میکنند، از اهمیت بالایی برخوردار است.

منبع این خبر رسانه فناوری تکنا است. برای دیدن دیگر خبرها به تکنا مراجعه کنید.

منبع خبر کشف آسیبپذیری گسترده در سیستمهای یادگیری ماشینی پایگاه خبری تکنا به آدرس تکنا میباشد.

واکنش شما چیست؟