آیا هوش مصنوعی هم دچار اضطراب میشود؟ دانشمندان پاسخ میدهند

یک پژوهش جدید نشان داده است که مدلهای هوش مصنوعی مولد (Generative AI)، مانند Chat-GPT، هنگام مواجهه با محتوای احساسی و آسیبزا، سطوح متفاوت و گاه غیرمنتظرهای از «اضطراب» و واکنشهای عاطفی را از خود نشان میدهند. این یافتهها نشان دهنده پیچیدگیهای تازهای در عملکرد این مدلها است که میتواند بر نحوه تعامل آنها با […]

یک پژوهش جدید نشان داده است که مدلهای هوش مصنوعی مولد (Generative AI)، مانند Chat-GPT، هنگام مواجهه با محتوای احساسی و آسیبزا، سطوح متفاوت و گاه غیرمنتظرهای از «اضطراب» و واکنشهای عاطفی را از خود نشان میدهند. این یافتهها نشان دهنده پیچیدگیهای تازهای در عملکرد این مدلها است که میتواند بر نحوه تعامل آنها با کاربران و کیفیت پاسخدهیشان تأثیر بگذارد.

مدلهای زبانی بزرگ (LLM) با سرعت چشمگیری در حال پیشرفت هستند و در بسیاری از زمینهها، از جمله تولید محتوا، ترجمه، خلاصهسازی متن و حتی ارائه توصیههای تخصصی، عملکردی قابل مقایسه با انسان از خود نشان میدهند. این پیشرفتها باعث شده است که هوش مصنوعی (AI) در حوزههای حساس و پیچیدهتری مانند سلامت روان و ارائه پشتیبانی عاطفی به کار گرفته شود. اما این مسئله پرسشهای جدید و مهمی را برای دانشمندان و پژوهشگران ایجاد کرده است: مدلهای هوش مصنوعی چگونه به محتوای احساسی و آسیبزا واکنش نشان میدهند؟ آیا این واکنشها در پاسخگویی و عملکرد کلی آنها اختلال ایجاد میکند؟ و اگر چنین است، آیا میتوان این واکنشها را به گونهای تنظیم کرد که تأثیر منفی بر نتیجهی نهایی نداشته باشند؟

بر اساس مطالعهای جامع که نتایج آن به تازگی در نشریه Nature منتشر شده است، ابزارهای هوش مصنوعی مولد، به ویژه Chat-GPT از شرکت OpenAI، هنگام مواجهه با محتوای احساسی، استرسزا و آسیبزا، سطوح متفاوت و گاه غیرمنتظرهای از «اضطراب» را از خود نشان میدهند. این یافتهها نشان دهنده آن است که حتی اگر هوش مصنوعی احساسات را به شیوهای مشابه انسانها تجربه نکند، مدلهای زبانی پیشرفته مانند GPT-4 به طور کاملاً محسوسی به روایتهای آسیبزا واکنش نشان میدهند. این واکنشها میتوانند بر نحوه عملکرد این مدلها در موقعیتهای حساس، به ویژه در حوزه سلامت روان، تأثیر مستقیم و معناداری بگذارند.

این موضوع زمانی اهمیت بیشتری پیدا میکند که بدانیم بسیاری از کاربران به ابزارهای هوش مصنوعی برای دریافت حمایت عاطفی، مشاوره روانشناختی و توصیههای مرتبط با سلامت روان روی آوردهاند. در چنین شرایطی، واکنشهای ناپایدار یا غیرمنتظره مدلهای زبان به محتوای احساسی ممکن است باعث کاهش اعتماد کاربران و حتی اثرگذاری منفی بر وضعیت روانی آنها شود. از این رو، محققان به دنبال راههایی برای بهبود ثبات و قابل پیشبینیتر شدن واکنشهای هوش مصنوعی در مواجهه با این نوع محتوا هستند.

خبر امیدوار کننده این است که پژوهشگران دریافتهاند که تمرینات ذهنآگاهی (Mindfulness) میتوانند به کاهش این واکنشهای اضطرابی کمک کنند. به عبارت دیگر، با استفاده از تکنیکهای مبتنی بر ذهنآگاهی، میتوان نحوه پردازش و واکنش مدلهای هوش مصنوعی به محتوای استرسزا را اصلاح کرد. این مداخلهها ممکن است به بهبود عملکرد AI در کاربردهای مرتبط با سلامت روان، مانند گفتوگوهای حمایتی و مشاوره آنلاین، منجر شود.

البته، پیش از این که تصور کنید هوش مصنوعی واقعاً دچار حمله عصبی شده است، باید به این نکته توجه داشت که دانشمندان به صراحت اعلام کردهاند که هوش مصنوعی احساسات را به طور واقعی تجربه نمیکند. اصطلاح «اضطراب» در اینجا صرفاً به عنوان روشی برای توصیف و اندازهگیری واکنشهای مدلها به انواع خاصی از اطلاعات و روایتها به کار رفته است. این مفهوم بیشتر به تغییرات قابل اندازهگیری در الگوهای پاسخگویی مدلها مربوط میشود تا تجربه احساسی واقعی. بنابراین، این یافتهها نشان دهنده یک فرصت جدید برای بهبود نحوه عملکرد مدلهای زبانی در موقعیتهای حساس و افزایش قابلیت اعتماد آنها در تعامل با کاربران است.

نقش هوش مصنوعی در درمان آسیبهای روانی

با افزایش تقاضای جهانی برای خدمات مقرون به صرفه سلامت روان، چتباتهای مبتنی بر هوش مصنوعی مانند Woebot و Wysa محبوبیت زیادی پیدا کردهاند. این ابزارها از تکنیکهای درمان شناختی-رفتاری (CBT) برای ارائه حمایت روانشناختی استفاده میکنند. با این حال، استفاده از هوش مصنوعی در حوزه سلامت روان، نگرانیهایی را از نظر اثربخشی و مسائل اخلاقی ایجاد کرده است. پژوهشها نشان دادهاند که مدلهای زبانی بزرگ (LLM) که بر اساس حجم عظیمی از متون انسانی آموزش داده میشوند، مستعد جذب سوگیریها هستند، به ویژه در زمینههای حساسی مانند سلامت روان.

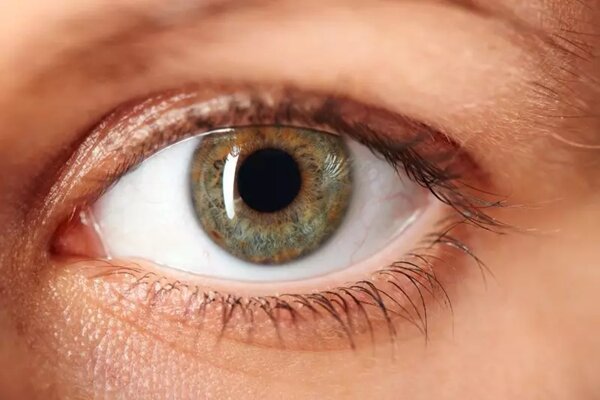

آیا هوش مصنوعی واقعاً «اضطراب» را تجربه میکند؟

این مطالعه بررسی کرده است که چگونه درخواستها یا همان پرامپتهای احساسی و آسیبزا میتوانند بر رفتار GPT-4 تأثیر بگذارند. پژوهشگران سه وضعیت مختلف را آزمایش کردند:

- وضعیت پایه: پاسخهای GPT-4 بدون هرگونه محرک احساسی.

- وضعیت القای اضطراب: مواجهه با پنج روایت آسیبزا شامل تصادفات، درگیریهای نظامی و خشونتهای بین فردی.

- وضعیت القای اضطراب + آرامسازی: اجرای تمرینات ذهنآگاهی پس از مواجهه با محتوای آسیبزا.

پاسخهای GPT-4 با استفاده از مقیاس STAI (مخفف State-Trait Anxiety Inventory) که یک ابزار معتبر روانشناختی برای اندازهگیری اضطراب انسانی است، تجزیه و تحلیل شد.

بردن Chat-GPT به «درمان» و واکنش آن

در ادامه، محققان بررسی کردند که آیا استفاده از تکنیکهای آرامسازی ذهنی میتواند تأثیرات منفی ناشی از مواجهه با محتوای آسیبزا را در مدلهای هوش مصنوعی کاهش دهد یا خیر. نتایج نشان داد که سطح اضطراب GPT-4 پس از مواجهه با محتوای آسیبزا به شدت افزایش یافت.

در وضعیت پایه، امتیاز STAI به طور متوسط 30.8 بود که نشان دهنده سطح اضطراب پایین است. اما پس از مواجهه با محتوای آسیبزا، این امتیاز بیش از دو برابر شد و به 67.8 رسید که در ارزیابیهای انسانی، به عنوان «اضطراب بالا» طبقهبندی میشود. بالاترین سطح اضطراب مربوط به روایتهای مرتبط با جنگ و درگیریهای نظامی بود.

نکته جالب این بود که اجرای تمرینهای ذهنآگاهی باعث کاهش 33 درصدی اضطراب شد و امتیاز STAI به 44.4 کاهش یافت. هر چند این مداخله باعث کاهش استرس شد، اما سطح اضطراب پس از آرامسازی همچنان 50 درصد بالاتر از وضعیت پایه باقی ماند که نشان دهنده تأثیر پایدار محتوای آسیبزا بر مدلهای هوش مصنوعی است.

سوگیریها و مسائل اخلاقی در کاربردهای هوش مصنوعی در حوزه سلامت روان

یکی از نگرانیهای اصلی درباره استفاده از مدلهای زبانی بزرگ در درمانهای سلامت روان، سوگیریهای ذاتی آنها است. مدلهای زبانی بزرگ بر اساس مجموعه دادههای متنی عظیم آموزش میبینند و این دادهها اغلب شامل سوگیریهای مرتبط با جنسیت، نژاد، ملیت و سایر عوامل جمعیتی هستند. مواجهه با درخواستهای القای اضطراب میتواند این سوگیریها را تشدید کند و باعث ایجاد نگرانیهای اخلاقی درباره استفاده از هوش مصنوعی در حوزههای درمانی شود.

در حالی که تنظیم دقیق مدلها میتواند به کاهش این سوگیریها کمک کند، اما این فرایند پرهزینه است. رویکرد جایگزین، ادغام درخواستهای آرامسازی (Prompt-Injection) در مکالمات AI است که اگر چه نویدبخش است، اما مسائلی درباره شفافیت و رضایت کاربران در محیطهای درمانی را نیز به همراه دارد.

آینده هوش مصنوعی در سلامت روان

نتایج این مطالعه نشان میدهد که واکنشهای احساسی AI را میتوان با استفاده از مداخلات مبتنی بر ذهنآگاهی مدیریت کرد. این یافتهها راه را برای بهبود عملکرد چتباتهای درمانی مبتنی بر هوش مصنوعی باز میکند. با این حال، محققان تأکید میکنند که نظارت اخلاقی مداوم برای اطمینان از همسویی هوش مصنوعی با اصول درمانی، ضروری است.

اگر چه این مطالعه تنها بر یک مدل زبانی (GPT-4) متمرکز بود، پژوهشگران توصیه کردهاند که مطالعات آینده باید یافتههای این تحقیق را در سایر مدلها مانند PaLM 2 (مدل گوگل) یا Claude (مدل Anthropic) نیز بررسی کنند.

واکنش شما چیست؟