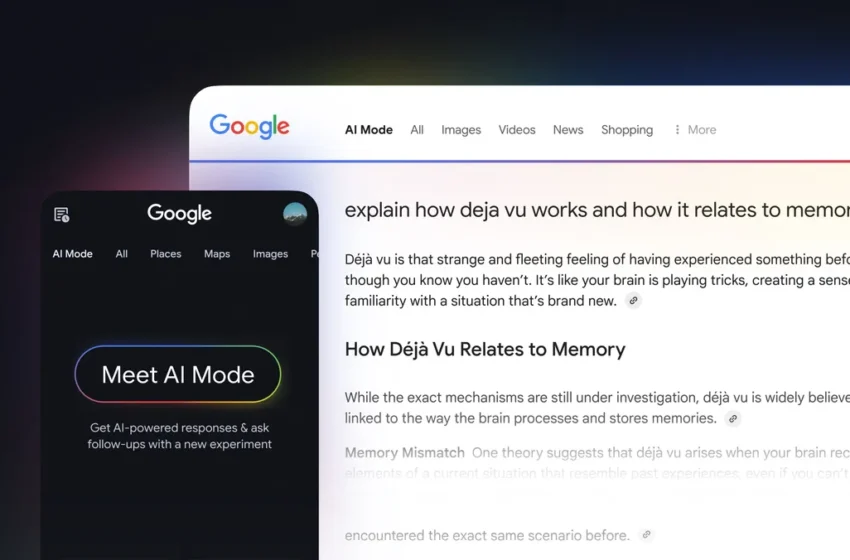

رقیب جدید DeepSeek؛ علیبابا از هوش مصنوعی خود رونمایی کرد

شرکت علیبابا مدل هوش مصنوعی جدید خود به نام QwQ-32B را معرفی کرده است. این مدل با ۳۲ میلیارد پارامتر طراحی شده و تمرکز آن روی حل مسائل پیچیده با استفاده از یادگیری تقویتی (RL) است. نکته مهم اینجاست که این مدل در عین داشتن کارایی بالا، به منابع پردازشی کمتری نسبت به رقبایی مثل …

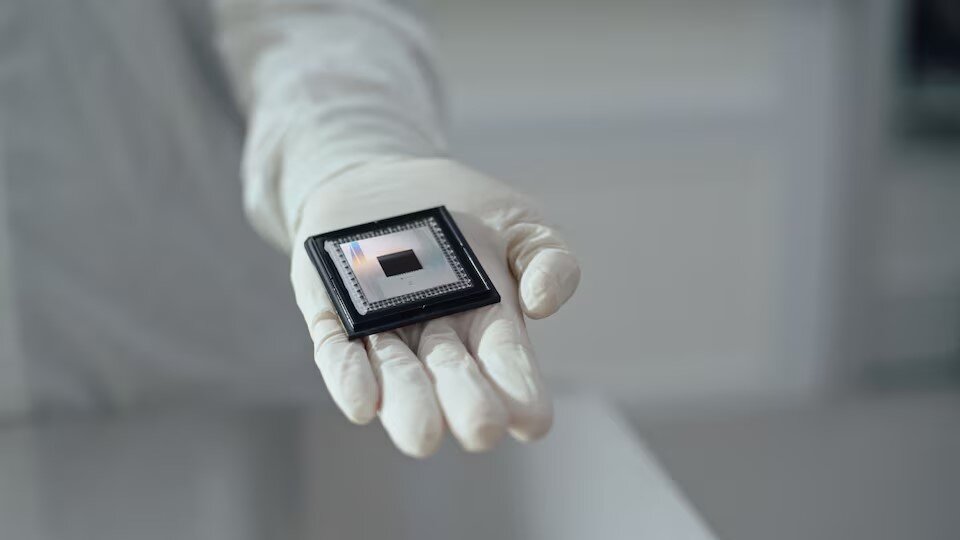

شرکت علیبابا مدل هوش مصنوعی جدید خود به نام QwQ-32B را معرفی کرده است. این مدل با ۳۲ میلیارد پارامتر طراحی شده و تمرکز آن روی حل مسائل پیچیده با استفاده از یادگیری تقویتی (RL) است. نکته مهم اینجاست که این مدل در عین داشتن کارایی بالا، به منابع پردازشی کمتری نسبت به رقبایی مثل DeepSeek-R1 نیاز دارد.

این مدل اپنسورس است و تحت مجوز Apache 2.0 منتشر شده، به این معنی که شرکتها و توسعهدهندگان میتوانند به راحتی از آن برای مقاصد تجاری و تحقیقاتی استفاده کنند.

رقیب جدید اوپن ای آی و DeepSeek

مدل QwQ مخفف (Qwen-with-Questions ) اولین بار در نوامبر ۲۰۲۴ معرفی شد. این مدل برای استدلال منطقی، حل مسائل ریاضی و برنامهنویسی بهینه شده است. در آزمایشهای اولیه، این مدل توانست از مدل o1-preview شرکت اوپن ای آی در زمینههای ریاضیات و استدلال علمی بهتر عمل کند، اما در برخی تستهای برنامهنویسی مثل LiveCodeBench هنوز نسبت به اوپن ای آی ضعیفتر بود.

با پیشرفت سریع مدلهای هوش مصنوعی، نیاز به مدلهایی که میتوانند در حین استدلال پاسخهای خود را بررسی و بهبود دهند افزایش یافته است. QwQ-32B نیز بر همین اساس توسعه یافته و از روشهای جدیدی برای بهبود دقت و عملکرد خود بهره میبرد.

کارایی بالاتر با منابع کمتر

یکی از نکات کلیدی این مدل این است که با مصرف منابع پردازشی کمتر، عملکردی نزدیک به مدلهای بسیار بزرگتر ارائه میدهد. به عنوان مثال، مدل DeepSeek-R1 دارای ۶۷۱ میلیارد پارامتر است، اما QwQ-32B توانسته با ۳۲ میلیارد پارامتر به سطح عملکردی مشابهی برسد. این یعنی مدل جدید علیبابا برای اجرا به کارتهای گرافیکی با ۲۴ گیگابایت حافظه نیاز دارد، در حالی که DeepSeek-R1 برای اجرا به ۱۶ کارت گرافیک A100 با بیش از ۱۵۰۰ گیگابایت حافظه نیازمند است.

بهبود عملکرد با یادگیری تقویتی

برای افزایش دقت، مدل در دو مرحله یادگیری تقویتی آموزش دیده است:

- تمرکز بر ریاضیات و کدنویسی: مدل با یک سیستم بررسی دقت ریاضی و سرور اجرای کد آموزش دیده تا پاسخهای درست را تقویت کند.

- بهبود کلی تواناییهای مدل: در این مرحله، مدل با روشهای مبتنی بر پاداش، دقت در پیروی از دستورالعملها و استدلال انسانی را بهبود بخشیده است.

کاربردهای تجاری و مزایای مدل

QwQ-32B میتواند برای تحلیل داده، برنامهریزی استراتژیک، توسعه نرمافزار و خودکارسازی فرآیندهای هوشمند مورد استفاده قرار گیرد. همچنین، اپنسورس بودن آن به شرکتها امکان میدهد تا آن را برای نیازهای خاص خود شخصیسازی کنند.

برخی کاربران ممکن است به دلیل اینکه این مدل توسط یک شرکت چینی توسعه داده شده، نگران امنیت دادهها و بیطرفی هنگان استفاده از آنها باشند، اما چون میتوان آن را از پلتفرم Hugging Face دانلود و بهصورت آفلاین اجرا کرد، این نگرانیها تا حدی برطرف میشود.

واکنش جامعه هوش مصنوعی

بعد از انتشار QwQ-32B، بسیاری از محققان و توسعهدهندگان هوش مصنوعی در شبکههای اجتماعی نظرات خود را درباره آن منتشر کردند:

- یکی از کارمندان Hugging Face اعلام کرده که این مدل در پردازش سریع است و حتی از مدلهای اوپن ای آیو DeepSeek-R1 بهتر عمل میکند.

- یک تحلیلگر فناوری و هوش مصنوعی تحت تأثیر عملکرد مدل قرار گرفته و گفته: “Qwen غوغا کرده است!”

- Yuchen Jin ، همبنیانگذار Hyperbolic Labs) ) نیز تأکید کرده که مدلهای کوچکتر به شدت قدرتمند شدهاند.

برنامههای آینده علیبابا

تیم Qwen قصد دارد در آینده روی بهبود مدلهای مبتنی بر یادگیری تقویتی، توسعه مدلهای پایه قویتر و حرکت به سمت هوش مصنوعی عمومی (AGI) کار کند.

مدل QwQ-32B نشاندهنده تغییر بزرگی در رویکرد توسعه هوش مصنوعی است و احتمالاً در آینده، مدلهای کوچکتر اما قدرتمندتر، جایگزین مدلهای عظیم و پرهزینه خواهند شد

واکنش شما چیست؟